OpenAI開發系列(二) 大語言模型發展史與Transformer架構詳解

隨著人工智能技術的飛速發展,大語言模型已成為推動自然語言處理領域的核心驅動力。本文將從計算機軟硬件開發及銷售的角度,系統梳理大語言模型的發展歷程,并深入解析作為其基石的Transformer架構。

一、大語言模型發展史:從理論到商業化的演進

大語言模型的發展,離不開計算機軟硬件技術的持續迭代與商業化應用。其演進路徑可概括為三個階段:

- 早期探索與統計模型階段(20世紀90年代-2010年代):此階段的模型以統計方法為主,如N-gram模型和隱馬爾可夫模型。這些模型受限于計算能力和數據規模,通常依賴于特定領域的小規模數據,且商業化應用集中在語音識別、基礎文本分類等有限場景。硬件以CPU為主流,軟件實現相對簡單。

- 深度學習與神經網絡興起階段(2010年代-2017年):隨著GPU在并行計算上的優勢被發掘,以及深度學習框架(如TensorFlow、PyTorch)的成熟,神經網絡模型開始主導。基于循環神經網絡(RNN)和長短時記憶網絡(LSTM)的序列模型得到廣泛應用,推動了機器翻譯、情感分析等商業化產品的落地。RNN系列模型存在訓練效率低、長程依賴處理能力弱等瓶頸。

- Transformer時代與大模型商業化爆發(2017年至今):2017年,Google在論文《Attention Is All You Need》中提出Transformer架構,徹底改變了自然語言處理的范式。OpenAI、Google、Meta等機構基于Transformer相繼推出GPT系列、BERT、T5等大語言模型。這些模型參數規模從數億擴展到數千億,依賴高性能GPU集群(如NVIDIA A100/H100)和分布式訓練框架進行開發。在銷售與應用層面,大語言模型通過API服務(如OpenAI的GPT API)、云平臺集成和行業解決方案等形式,廣泛賦能搜索引擎、智能客服、內容生成、代碼輔助等商業場景,形成了從硬件(專用AI芯片、服務器)到軟件(預訓練模型、微調工具)再到服務(SaaS、定制化開發)的完整產業鏈。

二、Transformer架構詳解:驅動大語言模型的核心引擎

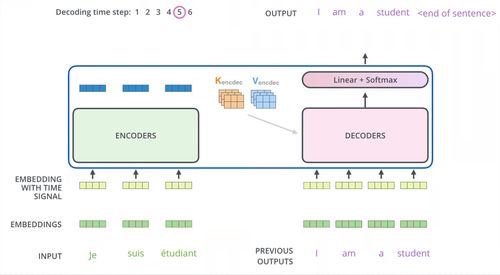

Transformer是一種完全基于自注意力機制的神經網絡架構,其設計兼顧了高效并行計算與強大的序列建模能力,成為當前大語言模型的標配。下面從計算機實現的角度解析其核心組件:

- 自注意力機制(Self-Attention):這是Transformer的核心創新。通過計算輸入序列中每個詞與其他詞的相關性權重,模型能夠動態捕捉長距離依賴關系。從硬件角度看,自注意力的大規模矩陣運算非常契合GPU的并行計算特性,顯著提升了訓練和推理效率。軟件實現上,通常采用優化后的矩陣庫(如CUDA加速)來保證計算速度。

- 編碼器-解碼器結構:原始Transformer包含編碼器和解碼器堆棧。編碼器用于理解輸入序列,解碼器用于生成輸出序列。在如BERT等模型中僅使用編碼器,而GPT系列僅使用解碼器。這種模塊化設計便于軟件層面的靈活調整與復用,支持不同任務(如理解vs.生成)的模型開發。

- 位置編碼(Positional Encoding):由于Transformer本身不具備序列順序信息,需要通過位置編碼為輸入添加位置信息。常見方式包括正弦余弦編碼或可學習的位置嵌入。這一機制在軟件實現上簡單高效,無需如RNN那樣的遞歸計算。

- 前饋神經網絡與殘差連接:每個注意力層后接一個前饋網絡,并采用殘差連接和層歸一化來穩定深度網絡的訓練。這有助于緩解梯度消失問題,使得訓練超深層模型(如GPT-3的1750億參數)成為可能,這對硬件(大內存、高帶寬)和軟件(梯度優化、分布式訓練)提出了極高要求。

- 規模化與硬件協同:Transformer架構的擴展性極強,模型性能隨參數規模和數據量增加而顯著提升。這驅動了專用AI硬件(如TPU、AI加速卡)的研發與銷售,以及配套軟件棧(如DeepSpeed、Megatron-LM)的優化,以降低大規模訓練的復雜度和成本。

大語言模型的發展史,本質上是算法創新、計算硬件升級與商業化探索交織的歷程。Transformer架構以其卓越的并行能力和擴展性,成為這一進程的關鍵轉折點。對于從事計算機軟硬件開發及銷售的企業與開發者而言,深入理解Transformer的原理及其在硬件加速、軟件框架和云端服務中的應用,是把握AI時代商業機遇的重要基礎。隨著模型壓縮、邊緣計算等技術的發展,大語言模型有望進一步向低成本、高能效的方向演進,開拓更廣闊的軟硬件市場空間。

如若轉載,請注明出處:http://www.ma6cci.cn/product/62.html

更新時間:2026-01-09 23:00:14